Catégorie : Technique

NTP et Chrony en conteneur

La mise en conteneur d’environnement est classique de nos jours et est indiscutablement nécessaire.

Certains, se sont maintes fois heurtés à un mur sous formes d’insultes systèmes en installant le service de temps sous Linux; et notamment sous CentOS/RedHat.

Installation de VyOS sur KVM/Qemu

VyOS est un système d’exploitation de routeur et firewall opensource. Vous trouverez leur site ici. On le retrouve dans les clouds AWS, Azure… et bien évidemment sur KVM. Très pratique, avec OpenVSwitch, il fait partie des petits blocs d’infra qui vous font économiser beaucoup d’heures de recherche et d’argent… Il s’interconnecte avec par exemple une “Azure VNet Gateway”, Wireguard, GRE, BGP over IKEv2/IPsec. L’OS consomme moins de 512M de RAM et prend quelques centaines de Mo de place en stockage.

Installation de l’OS

On va chercher la bonne image sur la bonne page du site de l’éditeur. Je suis sympa, je vous mets l’url. Dans mon infra de test KVM/libvirt, j’ai un switch virtuel (OpenVSwitch) sur une IP WAN (ext-br-network) et un réseau isolé (internal). On va créer une nouvelle VM dans libvirt :

virt-install -n vyos_r1 \

--ram 4096 \

--vcpus 2 \

--cdrom /var/lib/libvirt/images/vyos-1.3-rolling-202012041912-amd64.iso \

--os-type linux \

--os-variant debian10 \

--network network=ext-br-network,model=virtio \ # c'est un réseau sur mon OpenVSwitch sur le WAN

--network network=internal,model=virtio \ # c'est un réseau isolé

--graphics vnc,port=5999 \

--hvm \

--virt-type kvm \

--disk path=/var/lib/libvirt/images/vyos_r1.qcow2,bus=virtio,size=8 \

--noautoconsoleOn entre dans l’OS, on change les locales et on installe l’OS (ou pas, dans ce cas il est chargé en ram et il faut créer une image avec les scripts de configuration)

sudo loadkeys fr

sudo dpkg-reconfigure keyboard-configuration

install imageConfiguration simple avec deux cartes réseau

configure

set interfaces ethernet eth0 address dhcp

set interfaces ethernet eth1 address '192.168.200.254/24'

set service ssh port '22' # à partir de là le routeur est accessible en ssh, donc la conf peut-être terminée via SSH, Ansible

set nat source rule 100 outbound-interface 'eth0'

set nat source rule 100 source address '192.168.200.0/24'

set nat source rule 100 translation address masquerade

commit

save

exit

show interface

ping 8.8.8.8 interface 192.168.1.80 (en fonction)

ping 8.8.8.8 interface 192.168.200.254Configuration du DHCP si besoin

set service dhcp-server disabled 'false' # version <~ 1.1.8

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 default-router '192.168.200.254'

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 dns-server '192.168.200.254'

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 domain-name 'internal.domain.tld'

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 lease '86400'

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 start '192.168.200.10' stop '192.168.200.253' # version <~ 1.1.8

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 range 0 start '192.168.200.9'

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 range 0 stop '192.168.200.253'On configure le DNS forwarding

set service dns forwarding cache-size '0'

#set service dns forwarding listen-on 'eth1' # version <~ 1.1.8

set service dns forwarding listen-address '192.168.200.254'

set service dns forwarding allow-from '192.168.200.0/24'

set service dns forwarding name-server '8.8.8.8'

set service dns forwarding name-server '8.8.4.4'Voilà, à ce niveau le routeur est fonctionnel !

Mise en place des firewalls

set firewall name OUTSIDE-IN default-action 'drop'

set firewall name OUTSIDE-IN rule 10 action 'accept'

set firewall name OUTSIDE-IN rule 10 state established 'enable'

set firewall name OUTSIDE-IN rule 10 state related 'enable'

set firewall name OUTSIDE-LOCAL default-action 'drop'

set firewall name OUTSIDE-LOCAL rule 10 action 'accept'

set firewall name OUTSIDE-LOCAL rule 10 state established 'enable'

set firewall name OUTSIDE-LOCAL rule 10 state related 'enable'

set firewall name OUTSIDE-LOCAL rule 20 action 'accept'

set firewall name OUTSIDE-LOCAL rule 20 icmp type-name 'echo-request'

set firewall name OUTSIDE-LOCAL rule 20 protocol 'icmp'

set firewall name OUTSIDE-LOCAL rule 20 state new 'enable'

set firewall name OUTSIDE-LOCAL rule 30 action 'drop'

set firewall name OUTSIDE-LOCAL rule 30 destination port '22'

set firewall name OUTSIDE-LOCAL rule 30 protocol 'tcp'

set firewall name OUTSIDE-LOCAL rule 30 recent count '4'

set firewall name OUTSIDE-LOCAL rule 30 recent time '60'

set firewall name OUTSIDE-LOCAL rule 30 state new 'enable'

set firewall name OUTSIDE-LOCAL rule 31 action 'accept'

set firewall name OUTSIDE-LOCAL rule 31 destination port '22'

set firewall name OUTSIDE-LOCAL rule 31 protocol 'tcp'

set firewall name OUTSIDE-LOCAL rule 31 state new 'enable'et on applique la configuration à la carte réseau :

set interfaces ethernet eth0 firewall in name 'OUTSIDE-IN'

set interfaces ethernet eth0 firewall local name 'OUTSIDE-LOCAL'Automatisation

On peut exécuter un script pour automatiser la configuration, il doit être appelé par le groupe vyattacfg avec la commande switch group sg, ce qui donne :

sg vyattacfg -c ./conf-network.sh

#!/bin/vbash

source /opt/vyatta/etc/functions/script-template

configure

set interfaces ethernet eth0 address dhcp

set interfaces ethernet eth1 address '192.168.200.254/24'

set service ssh port '22'

set nat source rule 100 outbound-interface 'eth0'

set nat source rule 100 source address '192.168.200.0/24'

set nat source rule 100 translation address masquerade

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 default-router '192.168.200.254'

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 dns-server '192.168.200.254'

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 domain-name 'internal.domain.tld'

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 lease '86400'

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 range 0 start '192.168.200.9'

set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 range 0 stop '192.168.200.253'

set service dns forwarding cache-size '0'

set service dns forwarding listen-address '192.168.200.254'

set service dns forwarding allow-from '192.168.200.0/24'

set service dns forwarding name-server '8.8.8.8'

commit

save

exitAutre solution “maison”, un vieux script des familles qui permet de tout faire depuis l’hyperviseur :

#!/bin/bash

name="vyos_r1"

user="vyos"

password="vyos"

dns_ip="192.168.1.34"

function main() {

launch

sleep 40

install

sleep 10

config

}

function launch() {

sudo virt-install -n $name \

--ram 4096 \

--vcpus 2 \

--cdrom /var/lib/libvirt/images/vyos-1.3-rolling-202012041912-amd64.iso \

--os-type linux \

--os-variant debian10 \

--network network=ext-br-network,model=virtio \

--network network=internal,model=virtio \

--graphics vnc,port=5999 \

--hvm \

--virt-type kvm \

--disk path=/var/lib/libvirt/images/$name.qcow2,bus=virtio,size=8 \

--noautoconsole

}

function install() {

sudo expect <<EOF

set timeout 600

spawn virsh console $name

expect "Escape character is ^] (Ctrl + ])" {send "\n"}

expect "vyos login:" {send "$user\r"}

expect "Password:" {send "$password\r"}

expect "vyos:~" {send "install image\r"} expect "Would you like to continue? (Yes/No): " {send "Yes\n"}

expect "Partition (Auto/Parted/Skip):" {send "Auto\n"} expect "Install the image on?:" {send "\n"}

expect "Continue? (Yes/No):" {send "Yes\n"} expect "How big of a root partition should I create? (2000MB - 8589MB):" {send "8589MB\n"}

expect "What would you like to name this image?:" {send "\n"} expect "Which one should I copy to vda?:" {send "\n"}

expect "Enter password for user 'vyos':" {send "$password\n"}

expect "Retype password for user 'vyos':" {send "$password\n"}

expect "Which drive should GRUB modify the boot partition on?:" {send "\n"} expect "vyos:~" {send "sudo reboot\r"}

expect "Are you sure you want to reboot this system?" {send "Yes\r"}

EOF

}

function config() {

sudo virsh start $name

sleep 50

sudo expect <<EOF

set timeout 600

spawn virsh console $name

expect "Escape character is ^] (Ctrl + ])" {send "\n"}

expect "vyos login:" {send "$user\r"}

expect "Password:" {send "$password\r"}

send "sudo loadkeys fr\r"

send "configure\r"

send "set interfaces ethernet eth0 address dhcp\r"

send "set interfaces ethernet eth1 address '192.168.200.254/24'\r"

send "set service ssh port '22'\r"

send "set nat source rule 100 outbound-interface 'eth0'\r"

send "set nat source rule 100 source address '192.168.200.0/24'\r"

send "set nat source rule 100 translation address masquerade\r"

send "set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 default-router '192.168.200.254'\r"

send "set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 dns-server '192.168.200.254'\r"

send "set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 domain-name 'internal.domain.tld'\r"

send "set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 lease '86400'\r"

send "set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 range 0 start '192.168.200.9'\r"

send "set service dhcp-server shared-network-name LAN subnet 192.168.200.0/24 range 0 stop '192.168.200.253'\r"

send "set service dns forwarding cache-size '0'\r"

send "set service dns forwarding listen-address '192.168.200.254'\r"

send "set service dns forwarding allow-from '192.168.200.0/24'\r"

send "set service dns forwarding name-server '$dns_ip'\r"

send "commit\r"

send "save\r"

send "exit\r"

EOF

}

main

exit 0Et voilà, un routeur fonctionnel avec un seul script… Pensez à modifier ce script pour durcir la sécurité d’accès au routeur en changeant le second mot de passe et en modifiant la config ssh pour accepter les clés. Je mets le lien vers les blueprints de VyOS (notamment dans des environnements Cloud) :

https://docs.vyos.io/en/latest/configexamples/index.html

@+

Installer un bastion Teleport sur sa Freebox

En ces temps (confinés) de fêtes, j’ai pu prendre le temps de m’extraire de mon métier chronophage pour m’amuser un peu à la maison. Comme c’est Noël, je vous fais le cadeau de partager mon expérience, comme ça Xavier Niel vous revendra ce service dans quelques mois (comme on est en France, je précise pour protéger mon éditeur que c’est de l’humour ni blanc, ni noir).

J’ai choisi l’abonnement Free avec la freebox delta. Un peu cher mais qui permet finalement d’avoir un réseau 10Gb/s à la maison sans se ruiner. A part cela et le NAS intégré, la Delta restait un système relativement basique jusqu’au moment où les développeurs de Free ont eu la bonne idée d’implémenter le service KVM. Il permet de faire tourner des machines virtuelles… sur la box. L’idée est alors d’aller plus loin dans les services proposer par une box et par exemple mettre en place un vpn moderne (dans un prochain article) ainsi qu’un bastion (ou jumpbox). Un bastion va permettre de nous connecter au serveurs de notre réseau privé sans avoir à ouvrir un port sur l’extérieur, avec une double authentification. J’ai choisi ici de tester un bastion avec Teleport. Je vous laisse découvrir ces avantages avec Kubernetes, les Web Applications ou les Databases… je vais faire simple et rester sur du SSH over https.

Poursuivre la lecture « Installer un bastion Teleport sur sa Freebox »

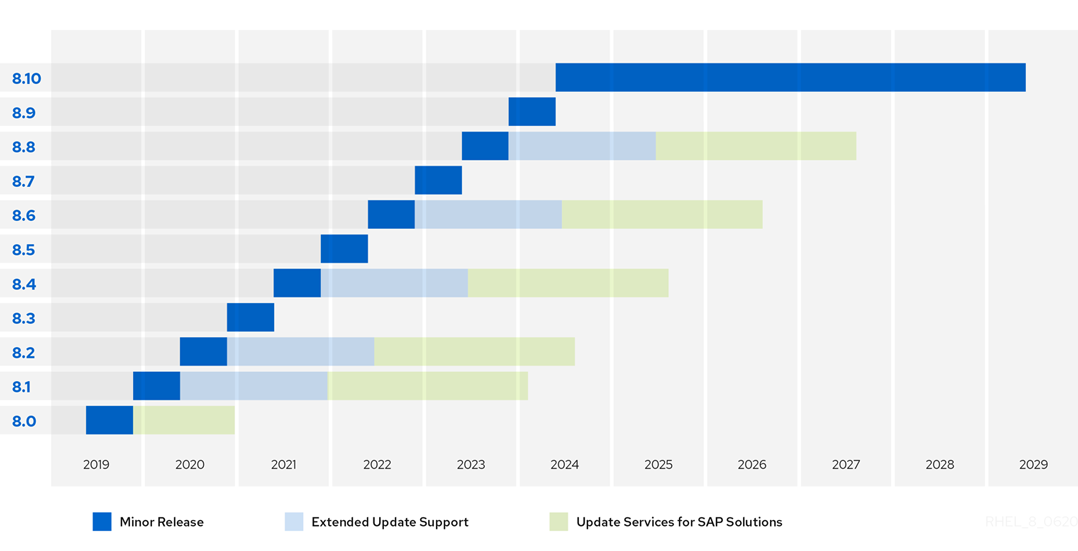

Les influences directes de la version Red Hat Entreprise Linux (RHEL) 8.0

Lors du dernier web-séminaire de RedHat, nous avons la confirmation du détail du cycle de vie des versions antérieures et actuelles de Linux RedHat. En résumé, et nous le savions déjà, la fin de support des versions antérieures à 8.0 depuis aout.

Version | General availability | Full support ends | Maintenance Support 1 ends | Maintenance Support 2 ends |

| 9 | A venir | A venir | ||

| 8 | 07/05/2019 | 8.0 (se termine le 31/12/2021) 8.1 (se termine le 30 novembre 2021) 8.2 (se termine le 30 avril 2022) 8,4 (se termine le 30 mai 2023) | N/A | 8.0 (se termine le 31/12/2021) 8.1 (se termine le 30 novembre 2021) 8.2 (se termine le 30 avril 2022) 8,4 (se termine le 30 mai 2023) |

| 7 | 10/06/2014 | 06/08/2019 | 06/08/2020 | 30/06/2024 |

| 7 (System Z) | 10/04/2018 | 06/08/2019 | 06/08/2020 | 31/08/2021 |

| 7 (Power9) | 13/11/2017 | 06/08/2019 | 06/08/2020 | 31/08/2021 |

| 7 (ARM) | 13/11/2017 | 06/08/2019 | 06/08/2020 | 30/11/2020 |

| 6 | 10/11/2020 | 10/05/2016 | 30/11/2020 | 30/11/2020 |

| 5 | 15/063/2007 | 31/01/2014 | 31/03/2017 | 30/11/2020 |

Rappel sur les matrices de fin de vie

RedHat nous confirme les fins de supports niveau 2 pour ces mêmes versions pour mai 2021 concernant les architectures non Intel/AMD; et enfin juin 2024 pour Intel/ADM.

RedHat vend évidemment sa solution Ansible pour pouvoir effectuer les migrations rapidement des systèmes anciens ou en utilisant son outil facilitant cette dernière: LEAPP. LEAPP est bien prêt pour passer en version 8.0 les anciennes versions de RedHat EL.

Concernant le cursus de certification RedHat 8.0, il reste inchangé…

Guide de planification RHEL 8

Cycle de vie RHEL

| Description | Support complet | Support de maintenance 1 (RHEL 6, & 7)12 | Support de maintenance (RHEL 8)13 Support de maintenance 2 (RHEL 6, & 7)12 | Phase de durée de vie prolongée7 | Module complémentaire ELS (Extended Life Cycle Support)8 | Module complémentaire EUS (Extended Update Support)8 |

|---|---|---|---|---|---|---|

| Accès au contenu précédemment publié via le portail client Red Hat | Oui | Oui | Oui | Oui | Oui | Oui |

| Auto-assistance via le portail client Red Hat | Oui | Oui | Oui | Oui | Oui | Oui |

| Soutien technique1 | Illimité | Illimité | Illimité | Limité9 | Illimité | Illimité |

| Errata de sécurité asynchrone (RHSA)10 11 | Oui | Oui | Oui | Non | Oui8 | Oui8 |

| Errata de correction de bogue asynchrone (RHBA)2 11 | Oui | Oui | Oui | Non | Oui | Oui |

| Versions mineures | Oui | Oui | Oui | Non | Non | Non |

| Activation matérielle actualisée3 | Indigène | Limité4 Indigène | Utilisation de la virtualisation | Utilisation de la virtualisation | Utilisation de la virtualisation | Utilisation de la virtualisation |

| Améliorations logicielles5 | Oui6 | Non | Non | Non | Non | Non |

| Images d’installation mises à jour | Oui | Oui | Oui | Non | Non | Non |

- L’accès au support technique dépend du niveau de service inclus dans votre abonnement Red Hat Enterprise Linux.

- Red Hat peut choisir, à titre de mesure temporaire, de résoudre ces problèmes catastrophiques ayant un impact significatif sur l’activité des clients avec un correctif pendant la création de l’avis d’errata de correction de bogues (RHBA).

- L’activation matérielle native est fournie par le rétroportage des pilotes matériels, etc., vers la version appropriée de Red Hat Enterprise Linux. L’activation matérielle à l’aide de la virtualisation est obtenue en exécutant une version antérieure de Red Hat Enterprise Linux en tant qu’invité virtuel sur une version plus récente de Red Hat Enterprise Linux. Consultez la description de la virtualisation ci-dessous pour plus de détails. REMARQUE : la certification matérielle (y compris les limites matérielles associées) s’applique à la version de Red Hat Enterprise Linux utilisée comme hôte.

- L’activation matérielle native dans la phase 1 du support de maintenance est limitée à l’activation matérielle qui ne nécessite pas de modifications logicielles substantielles. Consultez la description du support de maintenance 1 ci-dessous pour plus de détails.

- Les améliorations logicielles sont des ajouts de nouvelles fonctionnalités au-delà de la correction de défauts ou de l’activation de fonctionnalités existantes sur une nouvelle génération de matériel.

- Les versions majeures sont le principal vecteur d’améliorations logicielles importantes, bien que des améliorations logicielles à faible impact puissent également être fournies dans les versions mineures.

- Voir la description de la phase de durée de vie prolongée ci-dessous.

- La prise en charge étendue des mises à jour (EUS) et la prise en charge du cycle de vie étendu (ELS) sont disponibles en tant que modules complémentaires facultatifs. Voir les descriptions EUS et ELS ci-dessous.

- Pour les installations existantes uniquement. Voir les détails ci-dessous pour d’autres limitations.

- Consultez la page Classification de la gravité des problèmes pour obtenir des classifications de gravité de sécurité.

- Tous les errata sont fournis à la discrétion de Red Hat.

- S’applique aux versions majeures 6 et 7 de RHEL ; ne s’applique pas à RHEL 8.

- Le support de maintenance pour RHEL 8 est l’équivalent du support de maintenance 2 pour toute la phase de maintenance.

Plus de détails: ici

Construisez votre cluster de virtualisation AMD au format Mini-ITX

Ce n’est pas nouveau, mais beaucoup d’ingénieur en informatique ou développeur cherche perpétuellement la bonne configuration pour construire son serveur pour un lab ou plus.

La problématique est que l’encombre d’un serveur au format tour ou rack est avéré.

Si l’on cherche à se retrouver seul chez soi avec son serveur, au lieu de la personne avec qui nous vivons, c’est la bonne démarche !

Après une configuration à base de Shuttle et d’intel I7-8700 créée en 2017, je vous propose un nouveau challenge:

Un VRAI serveur AMD en format Mini-ITX.

Vous allez me rétorquer, “Pffffuu, facile….”. Mais là je vous parle d’un VRAI serveur avec une carte serveur sans l’équipement de carte vidéo.

“Aahhhh ?”. Eh bien oui ! 🙂

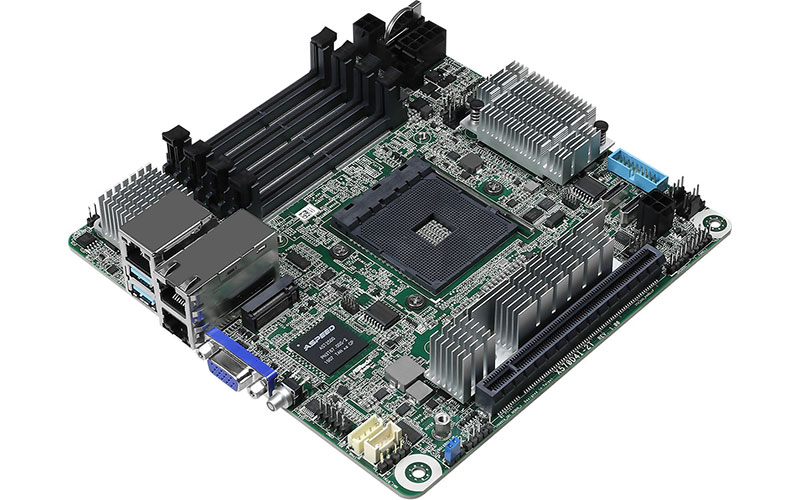

Après sa fameuse carte mère X470D4U au format ATX, ASRock Rack, la filiale d’ASRock, a publié courant janvier une nouvelle version de cette fameuse carte mère. Plus rapide et pourvu du chipset X570 devenu un standard pour les cartes mères à base de processeurs AMD.

Mais cela n’est pas tout. Cette carte est au format Mini-ITX.

Cette nouvelle au final avec les problématiques de COVID, à pris beaucoup…beaucoup de retard sur la production venant de Chine.

Les premières livraisons sont arrivées au compte-gouttes courant Juin dans certains pays en Europe, et Juillet/Aout en France.

Pour couronner le tout, certains composants comme les alimentations se sont fait attendre également. Autant dire que les approvisionnements sont tendues à cause de ces épisodes d’épidémies et partout dans le monde.

Voici donc un exemple de configuration que je vous propose en versus Mini-ITX.

Le cahier des charges

Un serveur avec un processeur AMD et dépassant 10 cœurs.

Pas de blocage d’évolution de la RAM à 32 ou 64GB

La possibilité de mettre plus de deux disque de stockage

Un budget raisonnable pour ce genre de configuration

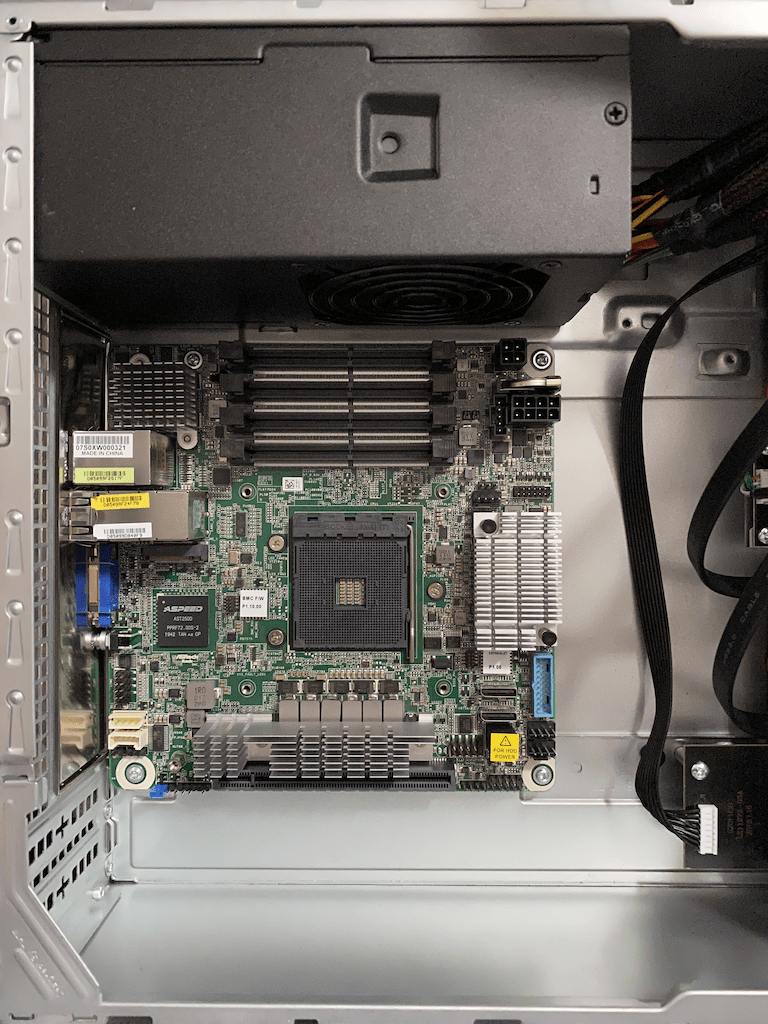

La carte mère

Cette X570D4I-2T est une bombe, et propose tous de sa petite sœur la X470. Attention cependant, cette carte mère est le premier centre de coût après le processeur. Comptez plus de 300€.:

1 socket AMD AM4 pour processeur AMD Ryzen 3000

4 Slots mémoire DDR4 2133/2400/2666/2933 MHz Dual-Channel (128 Go max.)

8 SATA 6Gb/s (par OCulink) avec le support RAID 0/1/10

1 x M.2 PCIe 4.0 x4 / SATA 6 Gbps

1 port PCI-Express 4.0 16x

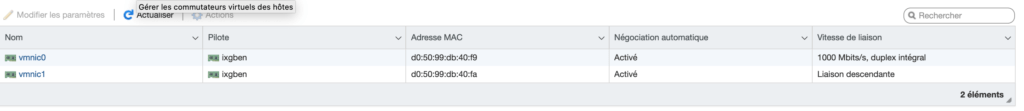

2 LAN 10 GbE Intel X550-AT2

1 port LAN mangement IPMI Realtek RTL8211E

1 Contrôleur Aspeed AST2500

Et oui, cette carte serveur possède sa carte graphique. Inutile de monopoliser un port PCI pour une carte graphique, car comme vous le savez, seul les AMD de la série Vega intègre le processeur graphique. Un sacré gain de place, de consommation. Et il nous reste un port PCI utilisable pour soit une carte graphique dédié pour du calcul GPU ou autre.

Il s’agit bien ici d’une carte mère serveur, car il y a la présence d’un BMC, car comme on peut le voir, un troisième port Ethernet est disponible. Il s’agit d’un port de management qui permet, comme beaucoup de carte mère serveur de prendre la main à distance (RSA, iLO, et cie). Et surtout de démarrer la carte mère et ses périphériques.

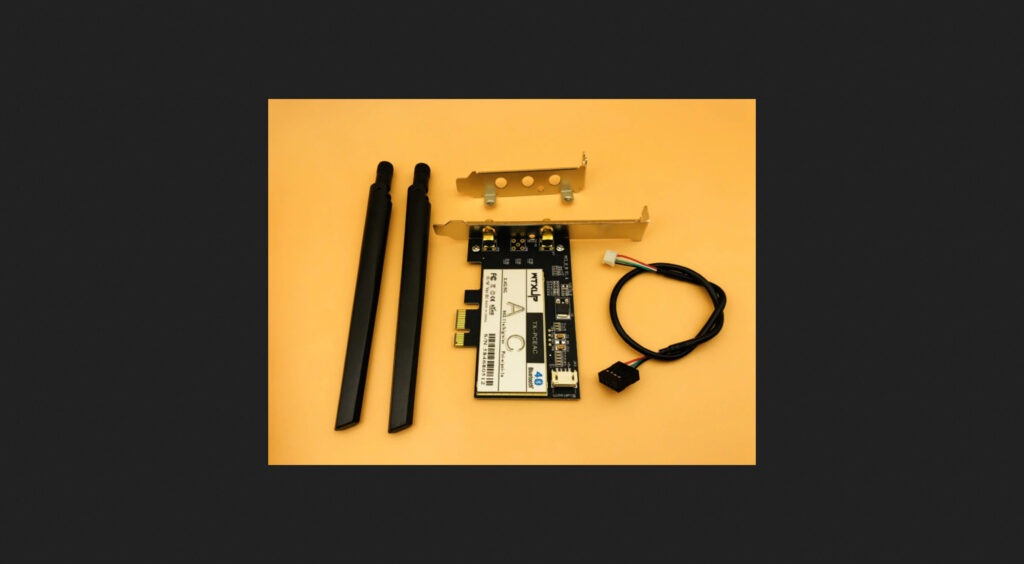

Add’On

Pour ajouter un petit plus (qui existait dans la configuration Shuttle), une carte Wifi en port PCI avec un chipset Intel, et … une puce bluetooth. De quoi être complet, non !?!

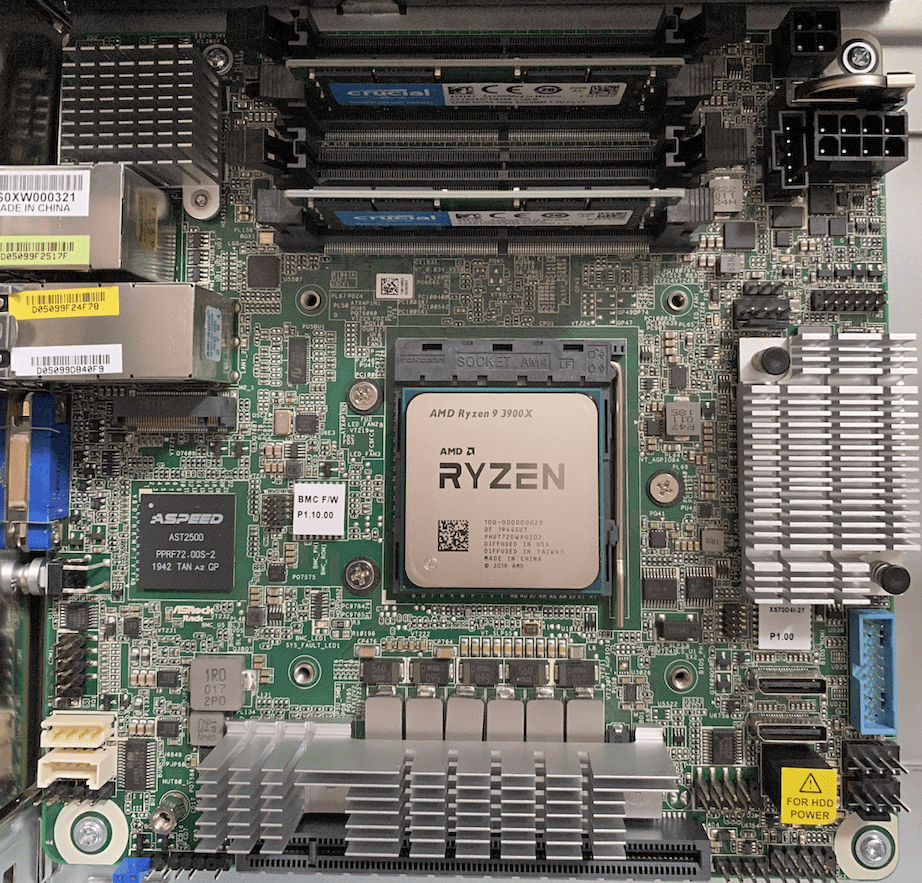

Le processeur

Deuxième centre de coût.

Mon objectif était de monté en puissance après ma configuration Shuttle à base d’Intel I7-8700.

Ainsi, de 12 Thread sur 6 Cœurs, j’ai fais le choix rapport/prix de passer à 12 Cœurs 24 Thread, soit doubler le compute.

Les EPYC étant trop cher, j’ai sélectionner le Ryzen 9 3900X 3800MHz.

La RAM

Troisième centre de coût. Le choix important et doit-être en compatibilité avec les recommandations constructeurs.

Deux barettes Crucial CT2K32G4SFD8266 propose ainsi 64 GB de RAM. Ainsi deux emplacements reste libre pour monter à 128GB la capacité maximale mémoire.

L’alimentation

Pour faire fonctionner cela, une bonne alimentation au format TFX, car au format Mini-ITX, c’est le format implicite.

J’ai choisi un bon rendement pour jouer la carte budget électrique et éviter des pertes dû au mauvais rendement. La TFX Power 2 300W Gold de chez BeQuiet me semblait une évidence pour rester dans un budget convenable. 300W, cela parait faible, mais cela est très suffisant, a moins d’utiliser des disques dur mécanique)

Le boitier

C’est très secondaire, mais au final, non. Il va accueillir tous l’ensemble et doit-être d’encombrement minimal. J’ai choisi le boitier BU12 de Chieftec, bien sur sans l’alimentation. Le boitier est de bonne facture pour un prix très raisonnable. Si on cherche à héberger beaucoup de disque dur il faudra changer pour un boitier un peu plus haut. Pour mon besoin, je suis parti pour deux unités à fortes capacités. (Nous en parlerons plus tard)

BU12 / Vue de derriere

BU12 / Vue de face

Ce boitier possède des emplacements 2,5″, 3,5″ et un pseudo 5 1/4″. Avec des berceaux d’adaptations à prix modique, il est donc possible de mettre en deux à quatre disque 2,5″.

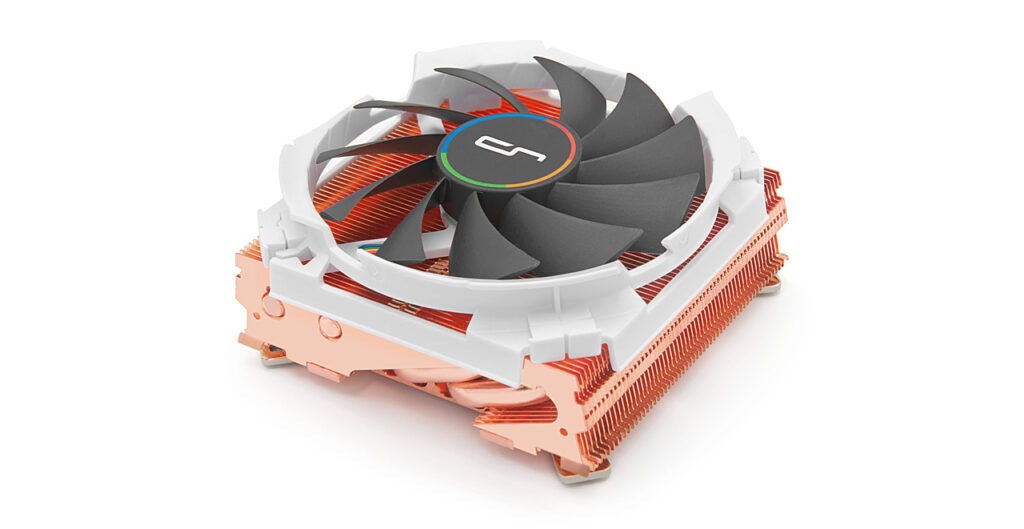

Le Refroidissement

C’est un choix important pour éviter d’avoir trop de bruit et avoir une ventilation efficace. Par rapport à la hauteur du boitier, le choix est très dirigé.

ATTENTION, ASRock impose un montage des ventilateurs au format LGA15xx, alors que le processeur est au format M2.

Certains constructeur de système de refroidissement propose des ventilateurs, ou ventirad pour les puristes, adaptables pour de nombreux format et cela peut import le socket du processeur.

C’est le cas du C7 de chez Cryorig, qui possède un look très sympa, sans cloisonnement qui provoque lorsque le ventilateur se voile, des bruits de frottement. La hauteur de ce ventirad nous laisse encore un petit de mou.

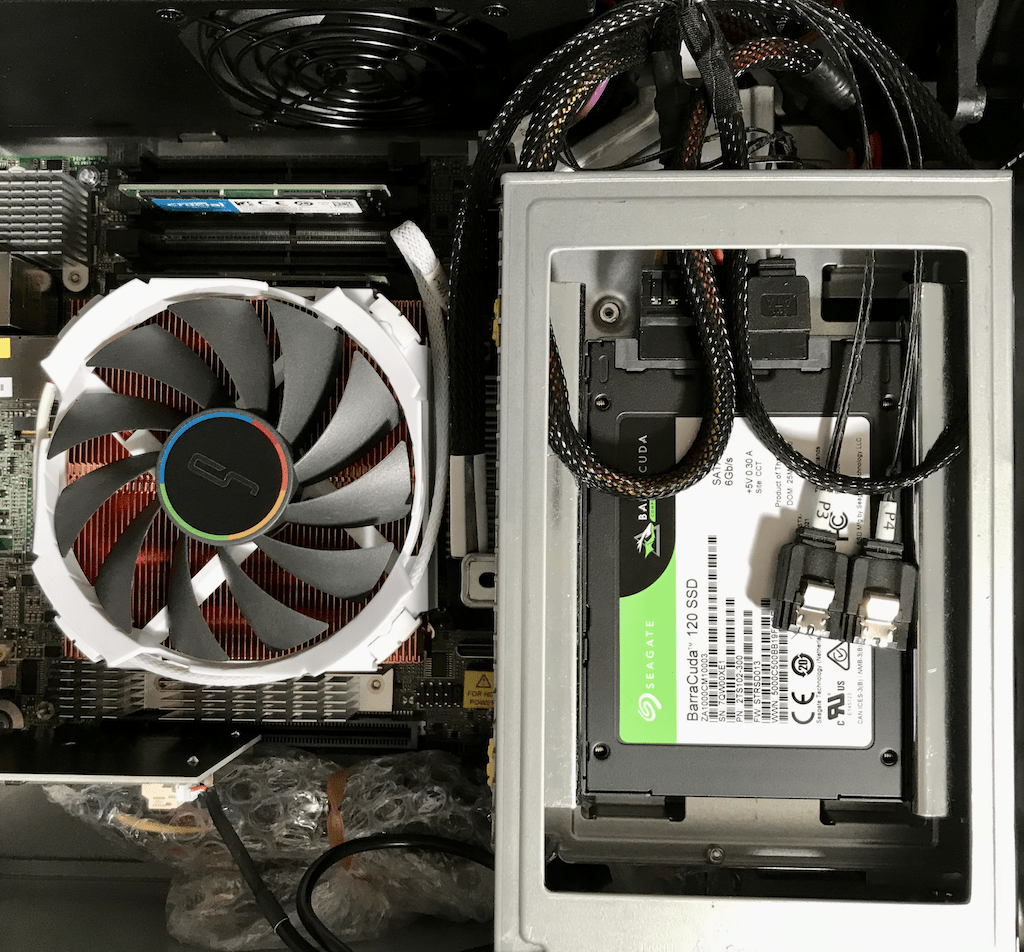

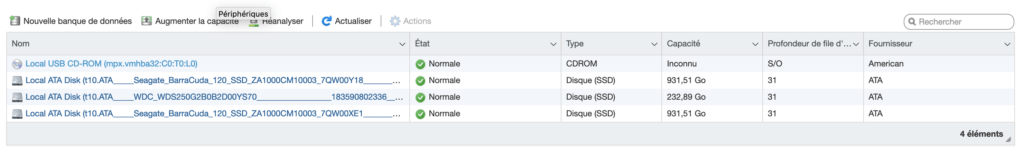

Le stockage

Comme je vous l’ai dit, j’ai choisi deux disques SATA SSD à fortes capacités. Selon son besoin, ils pourront être montés en RAID1 ou non en fonction. J’ai choisi un volume par disque Segate Baracuda 120 SSD. Ce choix est le meilleur compromis/prix avec IO supérieurs à Western Digital ou Crucial par exemple.

Enfin pour éviter de monopoliser l’un de ces pour le système de virtualisation, un disque M2 de 250 GB WD blue que je possédais. Très largement suffisant.

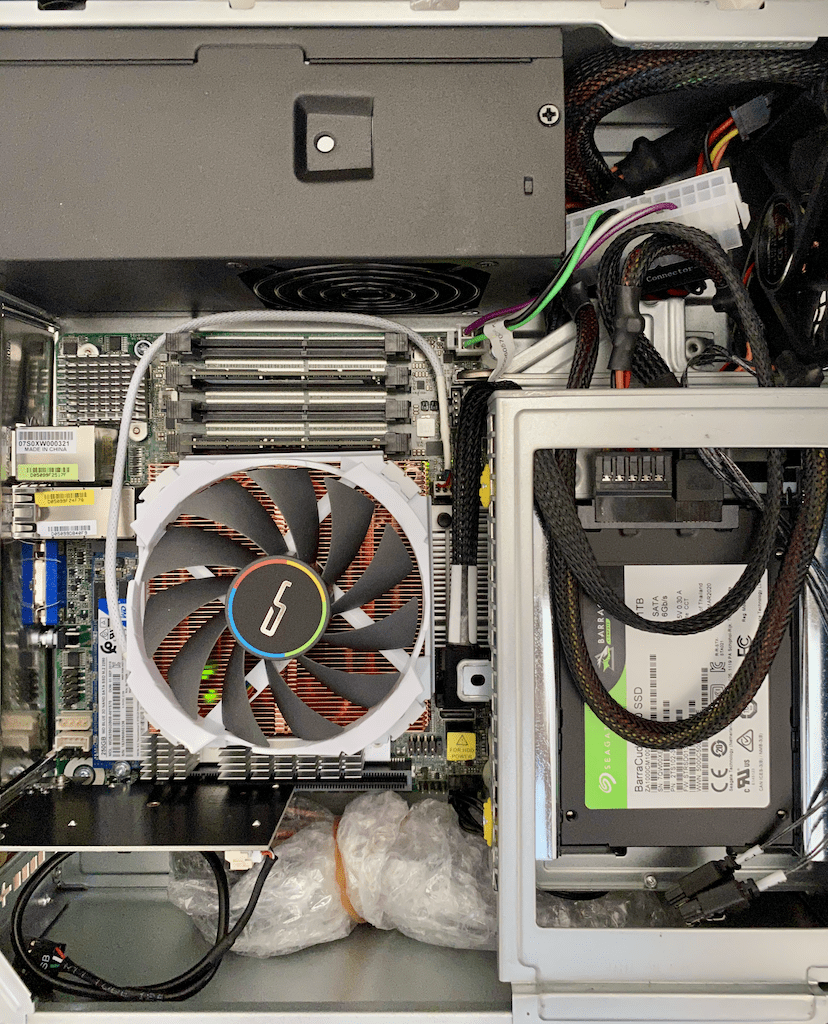

L’intégration

La carte mère s’intègre sans complication sur le boitier.

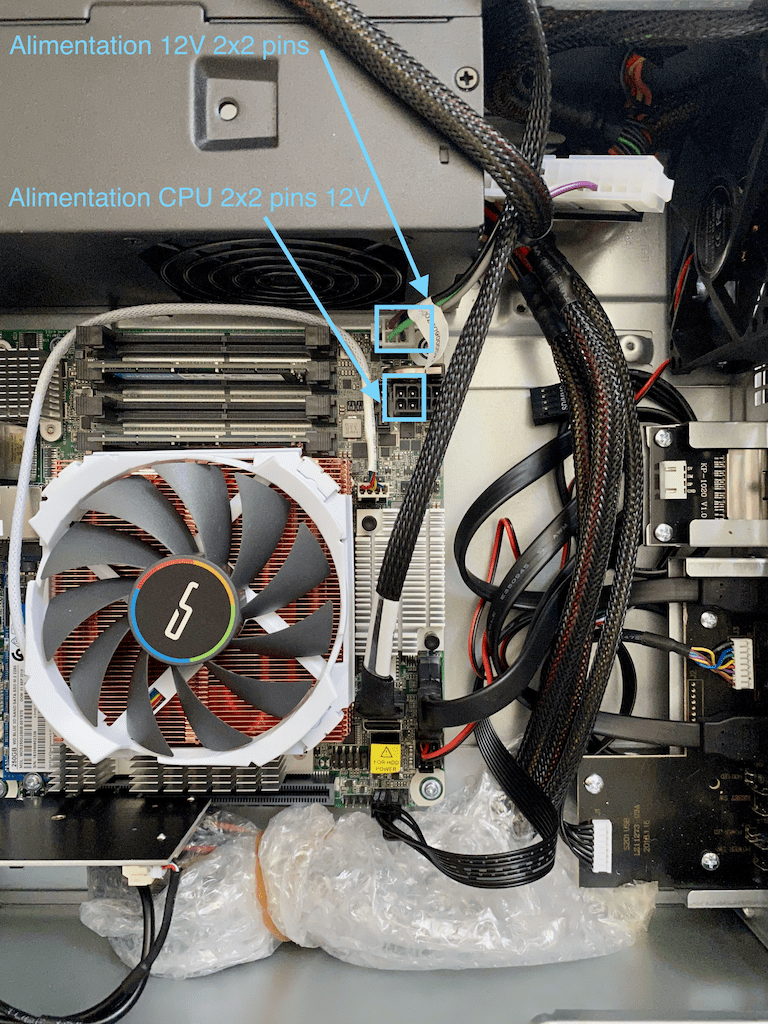

C’est côté alimentation que l’intégration doit-être soignée, car la place disponible est faible. Notamment près du ventilateur du boitier.

Une attention toute particulière est aussi sur le raccordement. Fourni avec l’alimentation TFX, BeQuiet! propose un adaptateur ATX vers ATX 12V. Il ne faut pas non plus oublier l’alimentation 12v du CPU, sinon la carte mère s’allumera de facto, mais sans CPU rien ne fonctionnera et sans aucune alerte sur la partie BMC.

Comme on peut le voir sur les illustrations, le raccordement des unités de disques de stockage SATA s’effectue par un câble OnLink. Attention ce câble est assez fin et peu, vite s’abimer. Via ce câble, quatre connexions SATA sont disponibles.

ATTENTION également, ASRock recommande d’utiliser les câbles d’alimentations venant de l’alimentation à découpage TFX et non de la carte mère pour éviter des dégradations de la carte mère. Tous dépends de l’alimentation utilisée ATX ou ATX12V.

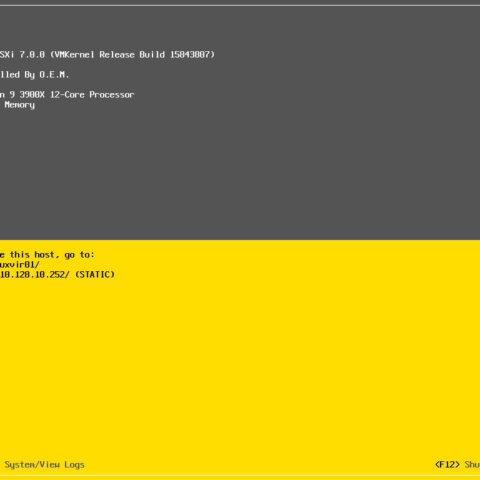

Installation de l’hyperviseur

Aspeed AST2500 oblige, il faudra se contenter d’un port vidéo VGA. Mais cela n’est pas forcément utile, car nous disposons de notre BMC. Et là tout se fait à distance !

Précaution, tout de même, utilisez la version Java de la prise à distance. Cela vous permettra d’avoir plus d’options à disponibilité.

Cela parait simple, mais il y a toujours des mauvaises estimations de compatibilité avec un hyperviseur ou un autre.

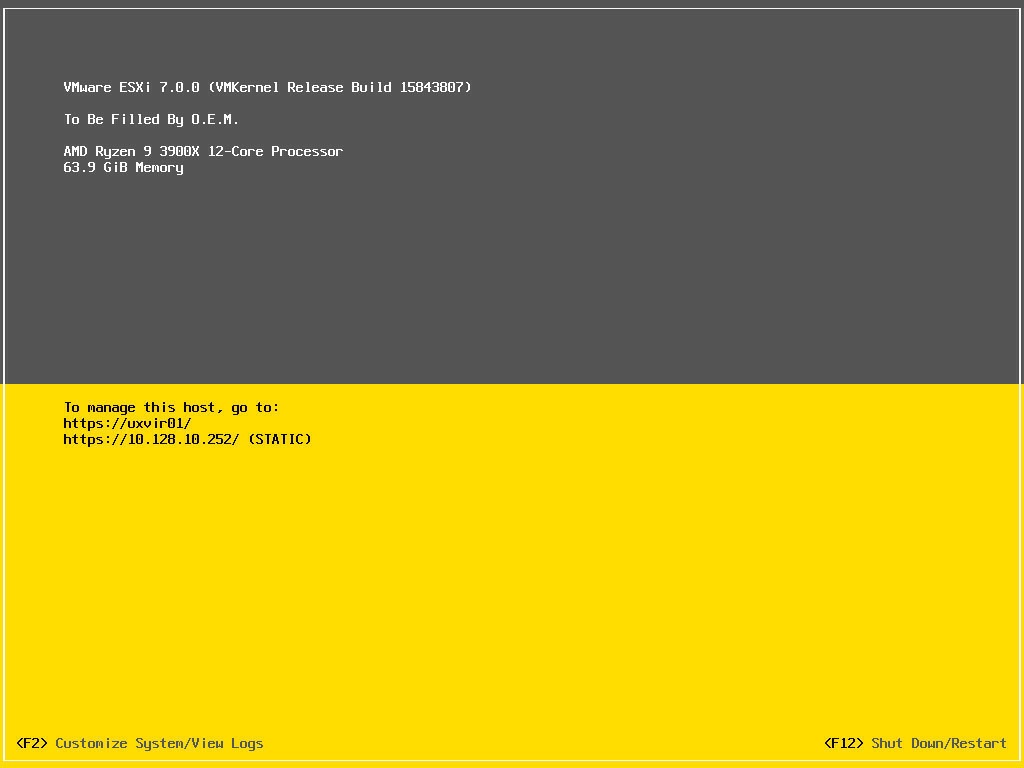

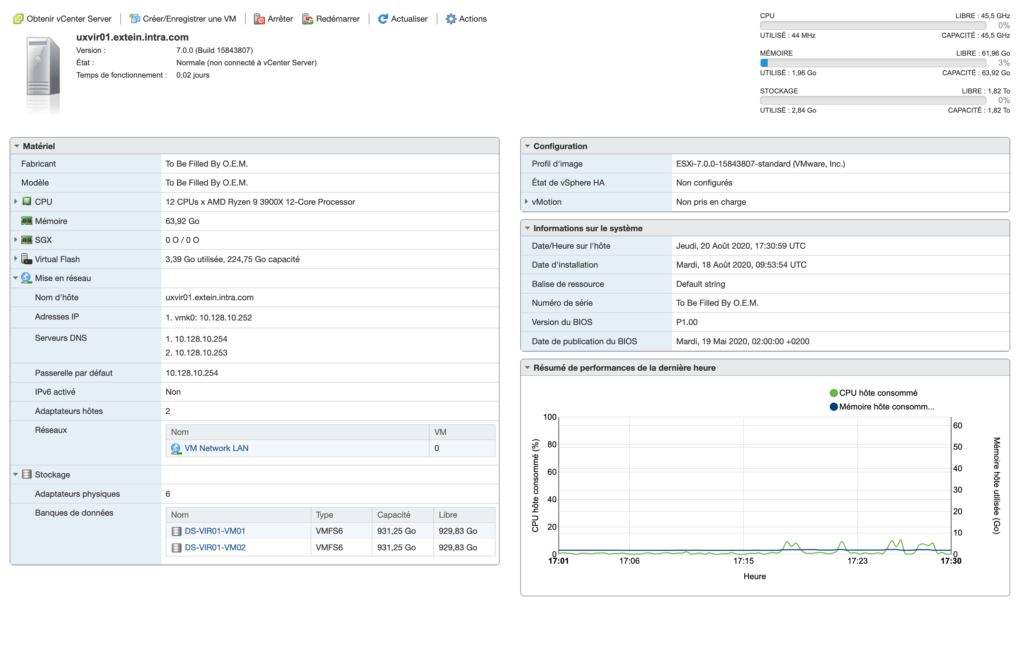

ESXi 7

Avant l’achat, il est évident que des vérifications de compatibilités ont été réalisé notamment avec VMware. L’objectif était également de pouvoir installer un ESXi 7. Comme vous le savez, les drivers de l’ESXi 7 ont été complètement ré-écrit, ce qui ne peut pas forcément arranger les choses.

Force de dire que l’installation passe comme une lettre à la poste. Même la carte WIFI grace à son chipset Intel, est reconnue.

J’ai poussé le bouchon un peu plus loin en virtualisant un hyperviseur Linux, Proxmox. Bien évidement il est important d’activer le partage de l’hyper threading et affecter un nombre suffisant de CPU dédié à cette VM.

Ainsi nous disposons, d’un hyperviseur ESXi, et d’un hyperviseur Proxmox afin de virtualiser des containers LXC/LXD.

Chacun y trouvera son compte.

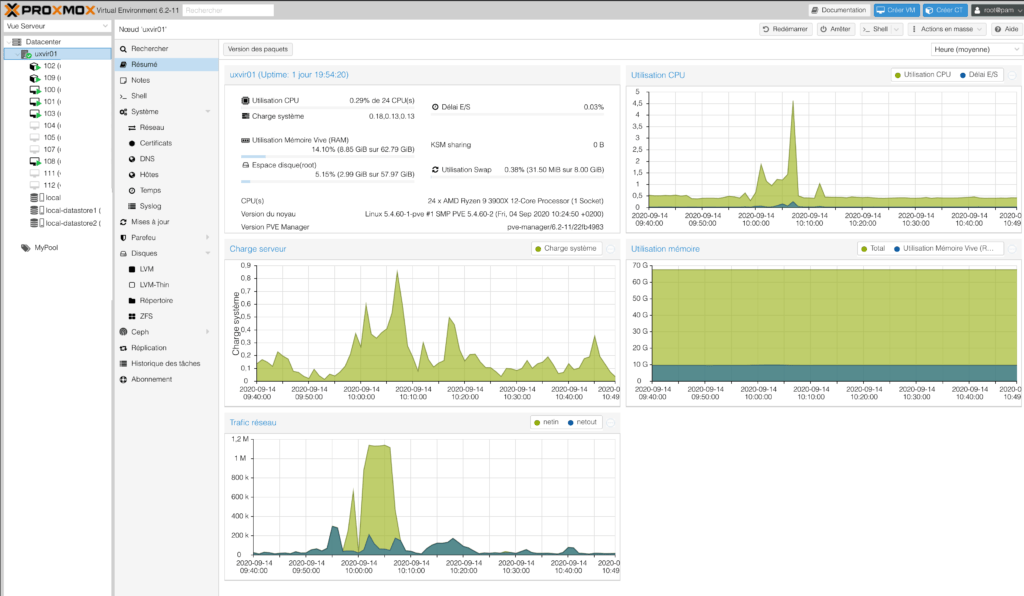

Proxmox 6.2.x

Installer un Proxmox au lieu d’un ESXi 7, ne pose aucun soucis de facto non plus. Noyau Linux oblige, c’est du gâteau !

Là aussi, tout est reconnu. Le petit plus, par rapport à une config Shuttle Intel, aucun besoin de toucher au configuration IOMMU pour éviter des instabilités, car ici TOUT est disponible et fonctionne sans rien faire.

Ainsi le partage en Pass-Thru des add’on PCI ou USB pour une VM, est fonctionnel.

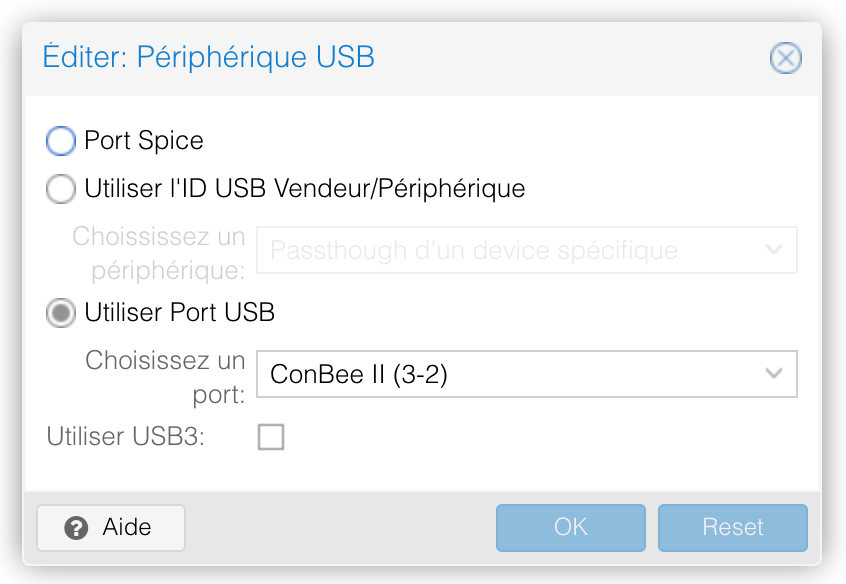

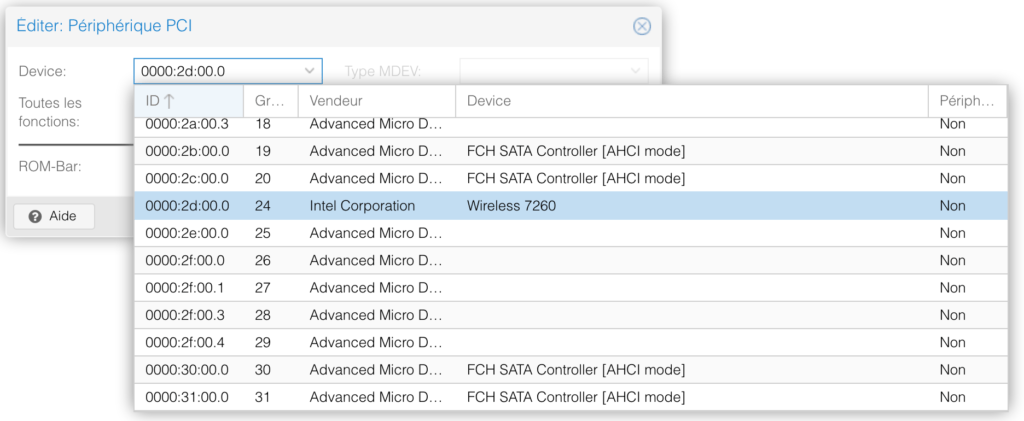

Deux exemples de VM avec leur port PCI ou USB en mode Pass-Thru.

Installer un ESXi en mode Nested ne pose non plus aucun soucis. Il suffit de réserver un certains nombre de ressources CPU en mode CPU-Host par exemple pour profiter d’un hyperviseur VMware sous Proxmox.

Pour rappel sous linux, il est impératif de paramétrer les modules modprobe en fonction du fondeur du cpu:

Activation du support nested

Il faut commencer par contrôler si le paramètre nested est activé ou pas dans le processeur :

cat /sys/module/kvm_intel/parameters/nested

ou

cat /sys/module/kvm_amd/parameters/nested

# N ou 0S’il est à N ou à 0, c’est qu’il n’est pas activé.

Pour activer l’activer, il suffit de positionner la variable à 1 à l’aide de la commande; Remplacez xxxx par le fondeur du cpu:

echo "options kvm-xxxx nested=1" > /etc/modprobe.d/kvm-xxxx.confIl faut ensuite redémarrer le module kvm. Pour cela il faut que toutes les vms soient arrêtée sur le serveur.

modprobe -r kvm-intel ou modprobe kvm-intelOn vérifie :

cat /sys/module/kvm_intel/parameters/nested

# Y ou 1Côté hyperviseur, on est prêt !

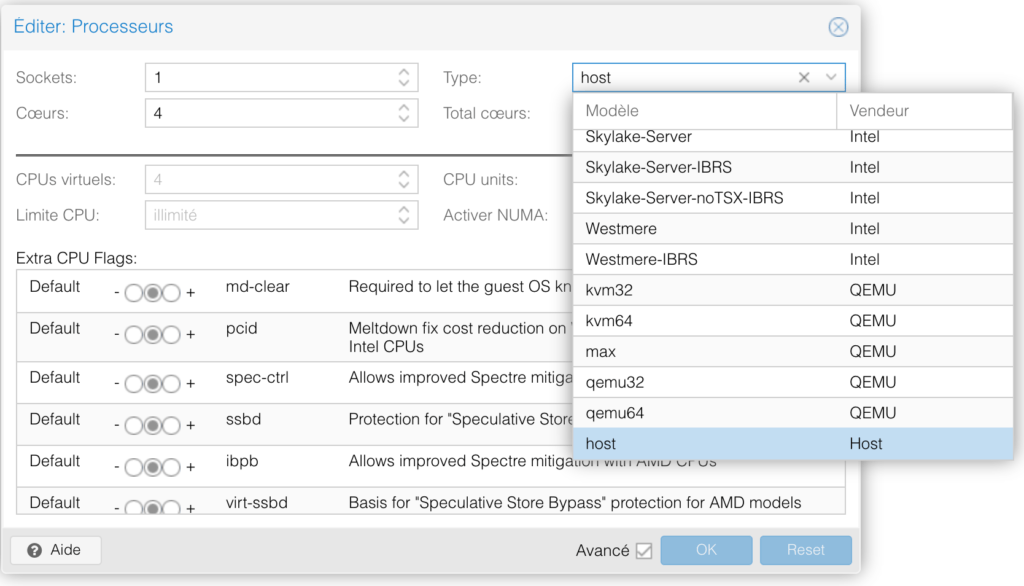

Coté guest-OS, plus particulièrement l’hyperviseur virtualisé, il est impératif de paramétrer au niveau de l’enveloppe du guest le type de cpu à host.

Puis également, même si ce n’est pas forcément impératif, ajouter le paramètre : args: -enable-kvm dans le fichier de conf de la vm (Par exemple : /etc/pve/qemu-server/106.conf

C’est tout ! Vous voilà prêt pour virtualiser un hyperviseur…Heu mais que dis-je ? 🙂

La boucle est bouclée !

Créer un Openstack Object Storage OVH avec Terraform pour backup Nextcloud

Bonjour à tous, cela fait un long moment que je n’ai pas eu l’opportunité d’écrire un article. Il y a quelques jours, j’ai eu besoin de relier un object storage OpenStack à un Nextcloud. J’ai décidé ensuite de l’automatiser avec terraform et l’inclure dans un module. Pour ceux qui ne connaissent pas les pratiques Objects Storage, je renvoie au site OpenStack. Comme d’hab, comme je suis chauvin, je vais utiliser un service cloud français : OVH. Bientôt et si le temps me le permet, j’utiliserai ma propre infra OpenStack sur plusieurs nodes : pour ça, j’ai enfin reçu mes cartes mères bi-xeon supermicro, mais tout est à construire, même le hardware donc à suivre…

Poursuivre la lecture « Créer un Openstack Object Storage OVH avec Terraform pour backup Nextcloud »